Conversazione con Andrea Santo Sabato — Lettura in 15 Min

Una riflessione sulle penalizzazioni

Conversazione con Andrea Santo Sabato — Lettura in 15 Min

Una riflessione sulle penalizzazioni

Cosa sono le penalizzazioni? Quali sono le principali pratiche scorrette? E come proteggere il proprio sito web?

Andrea Santo Sabato, responsabile SEO e co-fondatore di Natural Index, attinge alla sua ultradecennale esperienza nel settore per approfondire uno dei temi più importanti per un esperto di SEO o un digital marketer: la penalizzazione.

È un’intervista davvero a 360°, come nello stile di Andrea: si parla della “corsa a scalare la SERP”, dei core updates di Google, di bad SEO, di penalizzazioni algoritmiche e manuali, e soprattutto del metodo Natural Index per gestire una penalizzazione. E dall’intervista abbiamo anche tratto un post di sintesi, pubblicato qui.

Cosa sono le penalizzazioni? Quali sono le principali pratiche scorrette? E come proteggere il proprio sito web?

Andrea Santo Sabato, responsabile SEO e co-fondatore di Natural Index, attinge alla sua ultradecennale esperienza nel settore per approfondire uno dei temi più importanti per un esperto di SEO o un digital marketer: la penalizzazione.

È un’intervista davvero a 360°, come nello stile di Andrea: si parla della “corsa a scalare la SERP”, dei core updates di Google, di bad SEO, di penalizzazioni algoritmiche e manuali, e soprattutto del metodo Natural Index per gestire una penalizzazione. E dall’intervista abbiamo anche tratto un post di sintesi, pubblicato qui.

Andrea, partiamo dalle basi. Che cos’è una penalizzazione?

È la bestia nera di chiunque lavori nella SEO. Battute a parte, è la manifestazione di una “punizione” inflitta dal motore di ricerca al posizionamento, e pertanto alla visibilità, di un portale, di un e-commerce ecc. La penalizzazione si concretizza nel declassamento in SERP, e nel caso di Google tale retrocessione si verifica a causa di un upgrade o di un aggiornamento che il colosso di Mountain View apporta ai suoi algoritmi.

Per comprendere la ragion d’essere della penalizzazione, però, occorre una premessa che io ritengo di capitale importanza per inquadrare non soltanto il fenomeno “penalizzazione”, ma lo scenario di profonda trasformazione digitale che si sta dispiegando di fronte a noi. Com’è noto, nel mondo si sta verificando un boom di risorse da indicizzare. Oggi non c’è azienda, banca, dipartimento universitario, ente del turismo, museo d’arte, o rock band che non abbia il suo sito web. E conosciamo tutti la vastità dei portali delle grandi multinazionali o di certi e-commerce, che – se mi si concede un paragone ardito – sono complessi come le cattedrali gotiche del passato.

Il web è ogni istante più affollato perché è sempre più rilevante da qualsiasi punto di vista…

Esatto. Dalla Puglia alle Fiandre, dal Guangdong all’Oregon, non c’è entità, piccola o grande che sia, di tipo economico, accademico, scientifico, amministrativo, sociale, culturale e così via che non contribuisca ad allargare il web, attraverso un sito di tot pagine, attraverso un e-commerce e via discorrendo. E questo vuol dire, concretamente, che Google deve crawlare, ogni anno, miliardi di URI, unique resource identifier. Ciò, è evidente, fa impennare la complessità dell’universo del web in maniera esponenziale.

Ecco quindi che la “corsa a scalare la SERP” (e quindi a far apparire il proprio sito in cima alla pagina dei risultati della query) cresce ogni giorno di intensità. Questa competizione ha dei ritmi spasmodici, dal momento che arrivare in vetta porta immensi benefici, in termini di business, di visibilità, di reputazione.

E questa competizione al calor bianco si traduce anche in pratiche scorrette…

Oggi c’è chi cerca di scalare la SERP in modo molto poco etico, e poco rispettoso degli internauti e dei competitor. Si tratta di quella che in gergo viene definita bad SEO. E allo scopo di contrastare fenomeni derivanti dall’attuazione di tecniche di ottimizzazione non-naturali, eccessive e/o aggressive, Google periodicamente aggiorna i suoi algoritmi, in modo da riuscire a gestire, processare, comprendere e catalogare le risorse web in modo più efficace e fornire, alle ricerche degli utenti, risposte più coerenti e pertinenti.

Puoi dirci qualcosa in più sugli aggiornamenti?

Sono centinaia, e riguardano le decine e decine di algoritmi che fanno funzionare Google, ciascuno dei quali dedicato a (e differenziato funzionalmente per) uno specifico compito e scopo. Gli aggiornamenti più importanti di tutti sono senz’altro i core update, ossia delle modifiche sostanziali alle strutture del motore di ricerca, che vanno a impattare sulla maggior parte delle query; esempi a riguardo sono Hummingbird, Caffeine e da ultimo il December Update rilasciato, come suggerisce il nome stesso, lo scorso dicembre (il 4 dicembre 2020, per la precisione).

Dal 2018 tutti i core update vengono comunicati in modo ufficiale dal team di Google; dopo il rilascio dello Speed Update è nata la consuetudine di diramare delle comunicazioni ufficiali attraverso il seguitissimo canale Twitter Google Webmaster. Poco tempo fa, per esempio, è stato annunciato a breve il rilascio dell’Experience Page Update: un rilevante aggiornamento del core che andrà a rimodulare tutta l’assegnazione di rank e trust attraverso una nuova assegnazione di autorevolezza ai portali. Alcuni core update hanno natura algoritmica: si tratta, cioè, di modifiche al processo di elaborazione del ranking delle risorse che si traducono quindi in oscillazioni e fluttuazioni delle SERP; è il caso del Fred update o del Panda update. Ancora, i Refresh sono meri aggiornamenti e riallineamenti delle basi di dati degli algoritmi.

Vi sono poi i Filtri, vere e proprie esclusioni di un sito web da specifiche SERP appartenenti a cluster semantici legati a precisi gruppi di intenti di ricerca. In questo caso il portale, in alcuni ambiti semantici e keyword ben precisi perde la propria forza e la propria presenza in SERP. I Filtri sono innumerevoli, ad esempio Top Heavy, Pirate, EMD, filtro di cocitazioni di backlink, filtro sulle performance di overload di pagina, il Bombing e il Bowling filter, l’Architecture filter, il Boilerplate, il filtro 6 -30 – 60. Attraverso i Filtri il motore di ricerca rende un servizio prezioso all’utente.

E così come esistono vari tipi di aggiornamento, ci sono anche diverse categorie di penalizzazione?

Sì. Come dicevo, le penalizzazioni vanno intese come gli effetti negativi subiti da una risorsa web a fronte di un aggiornamento dell’algoritmo di Google. In merito c’è da fare una summa divisio. Da un lato vi sono le penalizzazioni algoritmiche, che sono appunto quel fenomeno legato direttamente al declassamento del Trust a fronte di un aggiornamento dell’algoritmo, e che vanno a incidere direttamente sulla visibilità in SERP rispetto a determinate keyword. Vi sono poi le penalizzazioni manuali, che sono il risultato di azioni rivolte a un ben preciso nome a dominio: tali azioni sono condotte dai Googlers e dagli Human Tester di Google, e talvolta (ma, ci tengo a sottolinearlo, solo talvolta) sono riportate nella proprietà della Search Console dei portali presi in esame alla voce Azioni Manuali.

Ma cosa spinge il motore di ricerca a considerare una risorsa o un sito web “meritevole” di subire un downgrade di visibilità o declassamento?

Beh, è una bella domanda. Per rispondere in modo non esaustivo, dato che la molteplicità dei casi fenomenologici è vasta (anzi, vastissima), posso dire che la punizione arriva quando si riscontra l’adozione di tecniche e attività considerate dal motore di ricerca come pratiche di ottimizzazione “forzate”, “ingannevoli” e “non naturali” definite anche tecniche “Black Hat”. Tali pratiche, peraltro, sono identificate e condannate nelle policy e best practice delle linee-guida ufficiali di Google.

Quali sono le principali pratiche scorrette?

Le elenco in maniera impressionistica; per rispondere bene a questa domanda servirebbe un post a sé. Dunque, c’è il Cloaking, metodo che a seconda dello User Agent mostra contenuti differenti rispetto a chi effettua una richiesta lato client; il Keyword stuffing, ovverosia la ripetizione ultronea ed eccessiva di parole-chiavi target in un testo per aumentarne la densità e promozione…

Andrea, partiamo dalle basi. Che cos’è una penalizzazione?

È la bestia nera di chiunque lavori nella SEO. Battute a parte, è la manifestazione di una “punizione” inflitta dal motore di ricerca al posizionamento, e pertanto alla visibilità, di un portale, di un e-commerce ecc. La penalizzazione si concretizza nel declassamento in SERP, e nel caso di Google tale retrocessione si verifica a causa di un upgrade o di un aggiornamento che il colosso di Mountain View apporta ai suoi algoritmi.

Per comprendere la ragion d’essere della penalizzazione, però, occorre una premessa che io ritengo di capitale importanza per inquadrare non soltanto il fenomeno “penalizzazione”, ma lo scenario di profonda trasformazione digitale che si sta dispiegando di fronte a noi. Com’è noto, nel mondo si sta verificando un boom di risorse da indicizzare. Oggi non c’è azienda, banca, dipartimento universitario, ente del turismo, museo d’arte, o rock band che non abbia il suo sito web. E conosciamo tutti la vastità dei portali delle grandi multinazionali o di certi e-commerce, che – se mi si concede un paragone ardito – sono complessi come le cattedrali gotiche del passato.

Il web è ogni istante più affollato perché è sempre più rilevante da qualsiasi punto di vista…

Esatto. Dalla Puglia alle Fiandre, dal Guangdong all’Oregon, non c’è entità, piccola o grande che sia, di tipo economico, accademico, scientifico, amministrativo, sociale, culturale e così via che non contribuisca ad allargare il web, attraverso un sito di tot pagine, attraverso un e-commerce e via discorrendo. E questo vuol dire, concretamente, che Google deve crawlare, ogni anno, miliardi di URI, unique resource identifier. Ciò, è evidente, fa impennare la complessità dell’universo del web in maniera esponenziale.

Ecco quindi che la “corsa a scalare la SERP” (e quindi a far apparire il proprio sito in cima alla pagina dei risultati della query) cresce ogni giorno di intensità. Questa competizione ha dei ritmi spasmodici, dal momento che arrivare in vetta porta immensi benefici, in termini di business, di visibilità, di reputazione.

E questa competizione al calor bianco si traduce anche in pratiche scorrette…

Oggi c’è chi cerca di scalare la SERP in modo molto poco etico, e poco rispettoso degli internauti e dei competitor. Si tratta di quella che in gergo viene definita bad SEO. E allo scopo di contrastare fenomeni derivanti dall’attuazione di tecniche di ottimizzazione non-naturali, eccessive e/o aggressive, Google periodicamente aggiorna i suoi algoritmi, in modo da riuscire a gestire, processare, comprendere e catalogare le risorse web in modo più efficace e fornire, alle ricerche degli utenti, risposte più coerenti e pertinenti.

Puoi dirci qualcosa in più sugli aggiornamenti?

Sono centinaia, e riguardano le decine e decine di algoritmi che fanno funzionare Google, ciascuno dei quali dedicato a (e differenziato funzionalmente per) uno specifico compito e scopo. Gli aggiornamenti più importanti di tutti sono senz’altro i core update, ossia delle modifiche sostanziali alle strutture del motore di ricerca, che vanno a impattare sulla maggior parte delle query; esempi a riguardo sono Hummingbird, Caffeine e da ultimo il December Update rilasciato, come suggerisce il nome stesso, lo scorso dicembre (il 4 dicembre 2020, per la precisione).

Dal 2018 tutti i core update vengono comunicati in modo ufficiale dal team di Google; dopo il rilascio dello Speed Update è nata la consuetudine di diramare delle comunicazioni ufficiali attraverso il seguitissimo canale Twitter Google Webmaster. Poco tempo fa, per esempio, è stato annunciato a breve il rilascio dell’Experience Page Update: un rilevante aggiornamento del core che andrà a rimodulare tutta l’assegnazione di rank e trust attraverso una nuova assegnazione di autorevolezza ai portali. Alcuni core update hanno natura algoritmica: si tratta, cioè, di modifiche al processo di elaborazione del ranking delle risorse che si traducono quindi in oscillazioni e fluttuazioni delle SERP; è il caso del Fred update o del Panda update. Ancora, i Refresh sono meri aggiornamenti e riallineamenti delle basi di dati degli algoritmi.

Vi sono poi i Filtri, vere e proprie esclusioni di un sito web da specifiche SERP appartenenti a cluster semantici legati a precisi gruppi di intenti di ricerca. In questo caso il portale, in alcuni ambiti semantici e keyword ben precisi perde la propria forza e la propria presenza in SERP. I Filtri sono innumerevoli, ad esempio Top Heavy, Pirate, EMD, filtro di cocitazioni di backlink, filtro sulle performance di overload di pagina, il Bombing e il Bowling filter, l’Architecture filter, il Boilerplate, il filtro 6 -30 – 60. Attraverso i Filtri il motore di ricerca rende un servizio prezioso all’utente.

E così come esistono vari tipi di aggiornamento, ci sono anche diverse categorie di penalizzazione?

Sì. Come dicevo, le penalizzazioni vanno intese come gli effetti negativi subiti da una risorsa web a fronte di un aggiornamento dell’algoritmo di Google. In merito c’è da fare una summa divisio. Da un lato vi sono le penalizzazioni algoritmiche, che sono appunto quel fenomeno legato direttamente al declassamento del Trust a fronte di un aggiornamento dell’algoritmo, e che vanno a incidere direttamente sulla visibilità in SERP rispetto a determinate keyword. Vi sono poi le penalizzazioni manuali, che sono il risultato di azioni rivolte a un ben preciso nome a dominio: tali azioni sono condotte dai Googlers e dagli Human Tester di Google, e talvolta (ma, ci tengo a sottolinearlo, solo talvolta) sono riportate nella proprietà della Search Console dei portali presi in esame alla voce Azioni Manuali.

Ma cosa spinge il motore di ricerca a considerare una risorsa o un sito web “meritevole” di subire un downgrade di visibilità o declassamento?

Beh, è una bella domanda. Per rispondere in modo non esaustivo, dato che la molteplicità dei casi fenomenologici è vasta (anzi, vastissima), posso dire che la punizione arriva quando si riscontra l’adozione di tecniche e attività considerate dal motore di ricerca come pratiche di ottimizzazione “forzate”, “ingannevoli” e “non naturali” definite anche tecniche “Black Hat”. Tali pratiche, peraltro, sono identificate e condannate nelle policy e best practice delle linee-guida ufficiali di Google.

Quali sono le principali pratiche scorrette?

Le elenco in maniera impressionistica; per rispondere bene a questa domanda servirebbe un post a sé. Dunque, c’è il Cloaking, metodo che a seconda dello User Agent mostra contenuti differenti rispetto a chi effettua una richiesta lato client; il Keyword stuffing, ovverosia la ripetizione ultronea ed eccessiva di parole-chiavi target in un testo per aumentarne la densità e promozione…

A proposito, il Keyword stuffing è famigerato.

In effetti sì… Tale tecnica, molto abusata in passato, con il Rank Brain e con l’adozione di protocolli DOM di Google per la comprensione del linguaggio naturale allo scopo di classificare e comprendere porzioni di testo è una delle cause di maggior penalizzazione sia algoritmica che manuale. Vi sono poi le matrici di link, utilizzate per manipolare e aumentare artatamente il Trust di un nome a dominio attraverso la creazione di reti e costellazioni di link (che a loro volta avranno degli anchors ben congeniati); tale attività serve a ingenerare un aumento della link popularity. Ancora, cito il Mirror (o Shadow) domain, ossia la creazione di portali clone (su nomi a dominio differenti) con contenuti duplicati in modo da poter generare aumenti di traffico artificiali.

E poi vorrei pure citare la Doorway page: si tratta, in poche parole, della realizzazione di pagine sovra-ottimizzate implementate non per gli utenti ma per i motori di ricerca, allo scopo di aumentare il traffico rispetto a keyword profilate e targetizzate. Last but not least, menziono il Testo duplicato e il Testo nascosto; una tecnica che comporta, in una pagina web, la duplicazione e ripetizione di eguali porzioni di testo o l’oscuramento di testo (ad esempio conferendo ai caratteri del testo un colore uguale allo sfondo), in modo da poter accrescere la ripetizione e la densità di determinate keyword.

Come proteggere un sito web da una penalizzazione?

Non esiste al mondo team di SEO o di digital marketing che non tema gli upgrade e gli aggiornamenti di Google. Pur seguendo con attenzione e perizia le linee-guida comunicate da Google, anche a noi di Natural Index (che pure abbiamo molti anni di esperienza in questo settore) talvolta capita che i progetti ottimizzati subiscano fluttuazioni di rilievo a fronte di un aggiornamento. Detto questo, in caso di declassamento, il consiglio che offro a ogni team è quello di… fare un bel respiro. La lucidità e il metodo sono gli strumenti migliori per gestire una situazione così delicata.

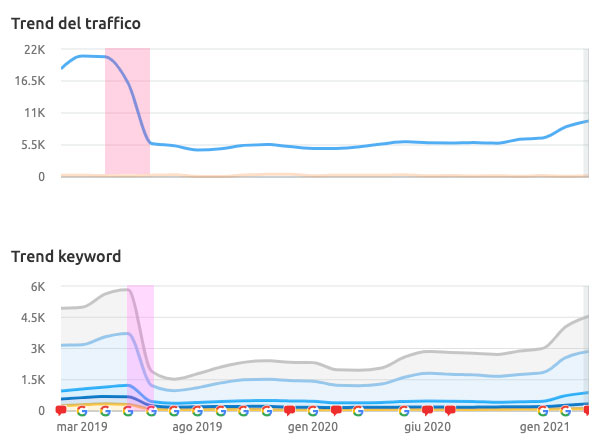

La prassi di Natural Index è la seguente: il team del gruppo procede ad analizzare il traffico del sito attraverso Analytics o sistemi di tracciamento, e se sono a disposizione anche strumenti di monitoraggio del tracking si verifica se il portale ha subito reali fluttuazioni e si controllano gli andamenti di determinate keyword. Quindi si procede a capire se sussistono problemi di natura tecnica legati al sito, e in parallelo se si sono verificati cambiamenti della SERP e delle ricerche legate alla stagionalità. Grazie a Search Console si ottiene una overview generale su KPI che possono fornire elementi preziosi per una comprensione maggiormente approfondita: CTR e Impression, l’average dei posizionamenti medi confrontandoli con le basi di dati storici; simuliamo inoltre la scansione con dei software di crawling per capire se il sito è idoneo a una scansione da parte dei bot di Google, analizziamo i log del web server, controlliamo con Google Lighthouse e con Page Speed Insight i vari fattori di performance, analizziamo i backlink, i tag e tutti fattori on-page e off-page che potrebbero indurre a pensare che il sito sia incappato in una penalizzazione.

Se un sito subisce una penalizzazione esiste qualche registro su Google dove se ne tiene traccia?

Purtroppo non esistono fonti esterne per capire se il sito web ha subito una penalizzazione di tipo algoritmico. Se invece il sito ha subito una penalizzazione manuale, essa verrà riportata in Search Console nella sezione Azioni Manuali. In questo caso sarà possibile comprendere la ragione della penalizzazione e, una volta risolto il problema o risolti i problemi, sarà possibile inviare al team di Google una richiesta di riconsiderazione.

Prima hai succintamente raccontato il metodo Natural Index quando si verifica una penalizzazione.

Quando si ha a che fare con una penalizzazione è fondamentale un’investigazione articolata e complessa, che richiede la capacità di individuare, come dei moderni Sherlock Holmes del web, i segnali indiretti della problematica, e sulla base di tali segnali bisogna costruire scenari e ipotesi di lavoro fattibili. Di solito per le penalizzazioni dovute a Filtri i tempi di recupero sono molto veloci (talvolta anche dopo quarantotto ore), mentre per le penalizzazioni manuali i tempi sono collegati alla presa in carico e al controllo manuale delle modifiche apportate. Per le penalizzazioni algoritmiche, invece, si deve attendere il rilascio di un nuovo core update.

Grazie mille Andrea.

Per me è un piacere. In Natural Index ci piace sempre confrontarci su questi temi cruciali.

Per conoscere meglio il lavoro di Natural Index, visita la sezione servizi.

A proposito, il Keyword stuffing è famigerato.

In effetti sì… Tale tecnica, molto abusata in passato, con il Rank Brain e con l’adozione di protocolli DOM di Google per la comprensione del linguaggio naturale allo scopo di classificare e comprendere porzioni di testo è una delle cause di maggior penalizzazione sia algoritmica che manuale. Vi sono poi le matrici di link, utilizzate per manipolare e aumentare artatamente il Trust di un nome a dominio attraverso la creazione di reti e costellazioni di link (che a loro volta avranno degli anchors ben congeniati); tale attività serve a ingenerare un aumento della link popularity. Ancora, cito il Mirror (o Shadow) domain, ossia la creazione di portali clone (su nomi a dominio differenti) con contenuti duplicati in modo da poter generare aumenti di traffico artificiali.

E poi vorrei pure citare la Doorway page: si tratta, in poche parole, della realizzazione di pagine sovra-ottimizzate implementate non per gli utenti ma per i motori di ricerca, allo scopo di aumentare il traffico rispetto a keyword profilate e targetizzate. Last but not least, menziono il Testo duplicato e il Testo nascosto; una tecnica che comporta, in una pagina web, la duplicazione e ripetizione di eguali porzioni di testo o l’oscuramento di testo (ad esempio conferendo ai caratteri del testo un colore uguale allo sfondo), in modo da poter accrescere la ripetizione e la densità di determinate keyword.

Come proteggere un sito web da una penalizzazione?

Bella domanda. Non esiste al mondo team di SEO o di digital marketing che non tema gli upgrade e gli aggiornamenti di Google. Pur seguendo con attenzione e perizia le linee-guida comunicate da Google, anche a noi di Natural Index (che pure abbiamo molti anni di esperienza in questo settore) talvolta capita che i progetti ottimizzati subiscano fluttuazioni di rilievo a fronte di un aggiornamento. Detto questo, in caso di declassamento, il consiglio che offro a ogni team è quello di… fare un bel respiro. La lucidità e il metodo sono gli strumenti migliori per gestire una situazione così delicata.

La prassi di Natural Index è la seguente: il team del gruppo procede ad analizzare il traffico del sito attraverso Analytics o sistemi di tracciamento, e se sono a disposizione anche strumenti di monitoraggio del tracking si verifica se il portale ha subito reali fluttuazioni e si controllano gli andamenti di determinate keyword. Quindi si procede a capire se sussistono problemi di natura tecnica legati al sito, e in parallelo se si sono verificati cambiamenti della SERP e delle ricerche legate alla stagionalità. Grazie a Search Console si ottiene una overview generale su KPI che possono fornire elementi preziosi per una comprensione maggiormente approfondita: CTR e Impression, l’average dei posizionamenti medi confrontandoli con le basi di dati storici; simuliamo inoltre la scansione con dei software di crawling per capire se il sito è idoneo a una scansione da parte dei bot di Google, analizziamo i log del web server, controlliamo con Google Lighthouse e con Page Speed Insight i vari fattori di performance, analizziamo i backlink, i tag e tutti fattori on-page e off-page che potrebbero indurre a pensare che il sito sia incappato in una penalizzazione.

Se un sito subisce una penalizzazione esiste qualche registro su Google dove se ne tiene traccia?

Purtroppo non esistono fonti esterne per capire se il sito web ha subito una penalizzazione di tipo algoritmico. Se invece il sito ha subito una penalizzazione manuale, essa verrà riportata in Search Console nella sezione Azioni Manuali. In questo caso sarà possibile comprendere la ragione della penalizzazione e, una volta risolto il problema o risolti i problemi, sarà possibile inviare al team di Google una richiesta di riconsiderazione.

Prima hai succintamente raccontato il metodo Natural Index quando si verifica una penalizzazione.

Quando si ha a che fare con una penalizzazione è fondamentale un’investigazione articolata e complessa, che richiede la capacità di individuare, come dei moderni Sherlock Holmes del web, i segnali indiretti della problematica, e sulla base di tali segnali bisogna costruire scenari e ipotesi di lavoro fattibili. Di solito per le penalizzazioni dovute a Filtri i tempi di recupero sono molto veloci (talvolta anche dopo quarantotto ore), mentre per le penalizzazioni manuali i tempi sono collegati alla presa in carico e al controllo manuale delle modifiche apportate. Per le penalizzazioni algoritmiche, invece, si deve attendere il rilascio di un nuovo core update.

Grazie mille Andrea.

Per me è un piacere. In Natural Index ci piace sempre confrontarci su questi temi cruciali.

Per conoscere meglio il lavoro di Natural Index, visita la sezione servizi.